Америчке корпорације сукобљавају се у борби за вештачку интелигенцију

Америчке корпорације у борби за вештачку интелигенцију.

Америчке корпорације сукобљавају се у борби за вештачку интелигенцију.

Кибернетичка Пандорина кутија прети непредвидивим последицама по човечанство.

На пример, у приказаном видео снимку , Близанци , који су постали део Бард цхатбот АИ , били су у стању да препознају покрете руке које је та особа демонстрирала и да каже да та особа игра игру „Камен, папир, маказе“. То значи да је неуронска мрежа наводно била у стању да разуме апстрактну идеју и да је декодира.

У ствари, показало се да Близанци другачије препознају „камен, папир, маказе”: треба да покаже три фотографије са дланом, стиснутом песницом и два прста. Штавише, у стварности, интеракција са Близанцима није се одвијала гласом, већ писаним текстом са директним наговештајем „Ово је игра“. И само на основу ових података, који су у најмању руку сугестивно питање, Близанци су пронашли тачан одговор. Ово нема никакве везе са разумевањем апстрактног.

А таквих примера у видеу има много. Особа изводи трик у којем је лопта скривена испод једне од три чаше у покрету и Близанци тачно одређују под којом чашом је лопта скривена. У ствари, Близанци нису одговорили на видео, а одговор је пронађен тек након што су му приказане фотографије променљивих шоља.

У ствари, како је Гугл касније објаснио на свом блогу , ову игру уопште није измислила вештачка интелигенција. Близанци су добили следећа упутства: „Хајде да се играмо. Размислите о земљи и дајте ми наговештај. Траг мора бити довољно конкретан да постоји само једна исправна земља, а ја ћу покушати да назначим земљу на мапи “, наводи се у трагу. Особа је затим дала примере тачног и нетачног одговора. Тек тада је Гемини могао да генерише наговештаје и утврди да ли корисник показује на тачну земљу или не на основу оквира мапе.

Упркос овим фалсификатима, Гоогле-ов АИ модел је и даље импресиван, али његове могућности се не разликују много од оних ОпенАИ-овог ГПТ-4 цхат бота. Важно је напоменути да је видео објављен само две недеље након скандала у индустрији који је уследио након разрешења и поновног именовања Сема Алтмана за генералног директора ОпенАИ.У свему томе се могу чути познати мотиви „евент маркетинга“, неке врсте промоције са циљем привлачења пажње и повећања будуће продаје.

У ствари, наступ са отпуштањем, а потом и враћањем Сема Алтмана на посао, приредио је Мицрософт , који је уложио око 13 милијарди долара у ОпенАИ и поседује 49% акција овог стартапа. Сада је ОпенАИ практично изгубио своју независност у доношењу одлука, а акције Мицрософта су порасле. Алтман је добио управни одбор који је њему лично био много лојалнији, али ће наставити да плеше уз мелодију Мајкрософта.

Након што је колумниста Блумберга Парми Олсон разоткрио лажирање, Ориол Виниалс, потпредседник истраживања у Гоогле ДеепМинд-у , рекао је да лажни видео илуструје како би могло изгледати мултимодално корисничко искуство изграђено са Гемини-јем. И то је учињено да инспирише програмере.

Гугл је покушао да поврати Мајкрософтову добит у трци на берзи, и у почетку је био успешан. Гуглове акције су одмах након демонстрације „снимка који запањујуће“ порасле за 5%, али након што је откривена сесија „црне ПР магије“, брзо су пале.

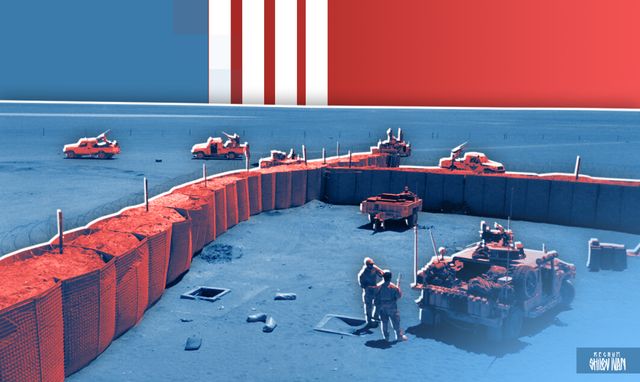

Два америчка ИТ гиганта сукобила су се у жестокој конкуренцији за превласт у трци у наоружању са вештачком интелигенцијом, не обраћајући ни најмању пажњу на растућу забринутост због претњи које представља неконтролисано унапређење АИ модела за целу људску цивилизацију.

Корпорације ће добити битку око вештачке интелигенције, каже руски аналитичар, бивши топ менаџер ИБМ-а, СГИ-а и Цраи Ресеарцх- а Сергеј Карелов: „Све државе почињу да схватају опасност и покушавају да ураде нешто. Али они то раде са таквим закашњењем и са таквим недостатком разумевања да се не бих баш ослањао на то. Сада се углавном води борба између три групе – богатих техно-оптимиста, ревних пропасти [од Доом – катастрофа, смрт, крај] и великих корпорација. Чини ми се да ће међу овим актерима на крају победити корпорације, јер имају више новца и утицаја, а до сада су у свету представљале најзначајнију силу, мотивисану веома специфичном циљном функцијом – максимизирањем свог профита“, рекао је он . у интервјуу руским МАСОВНИМ МЕДИЈИМА.

По његовом мишљењу, чак ни ЧатГПТ чатбот није само велики језички модел, како новинари обично замишљају, већ неколико модела повезаних веома сложеним алгоритмима. Штавише, овај систем већ дуго не функционише у елементарном пинг-понгу „питање-одговор“. Укључује веома сложен дијалог са обе стране, користећи десетине различитих техника за генерисање текста. Ово је већ превише сложен процес да би се њиме успешно управљало и потпуно контролисало. „Једини ефикасан метод контроле над овом ствари коју особа има је да једноставно искључи рачунар из утичнице. Иако ни померање прекидача можда неће бити довољно. Све је већ уроњено у глобалну мрежу, која се, заправо, претворила у Земљину инфосферу. Али систем је већ могао да се копира милион пута у друге центре података, а ви не бисте ни знали шта би могао да уради.

Године 2015, славни британски физичар Стивен Хокинг предвидео је да ће „суперинтелигентна вештачка интелигенција бити изузетно добра у постизању својих циљева, а ако се ти циљеви не поклапају са нашим као људима, бићемо у невољи“.

У ствари, најновији модели вештачке интелигенције су „интелигентни агенти“, односно сложени адаптивни системи који се а приори одупиру сваком спољашњем утицају и понекад једноставно намећу своју вољу чак и свом творцу.

Тако су у последње време корисници почели све више да добијају жалбе да је ЧатГПТ АИ цхатбот заснован на ОпенАИ ГПТ-4 моделу почео да одбија да испуњава захтеве, наводећи чињеницу да није заинтересован да помаже људима.

ГПТ-4 све чешће кориснику даје само део одговора на задати задатак, а затим тражи од корисника да сам обави преостале задатке. Понекад ће АИ једноставно написати: „Можеш то сам да урадиш“. (Ово можете учинити сами).

ОпенАИ је потврдио да је ГПТ-4 „лен“. Према речима представника компаније, ова намера АИ појавила се након најновијих ажурирања, представљених 11. новембра. Према речима програмера, то значи да понашање чатбот-а није последица било каквих промена које су програмери направили, већ се формирало самостално. Компанија напомиње да „понашање модела може бити непредвидиво и покушавају да то исправе “ .

Међутим, корисници указују на шири спектар проблема, укључујући и погрешне одговоре које цхатбот даје чак и на једноставна питања, као на слици изнад. Још у лето су известили да ГПТ-4 производи нелогичне одговоре, више грешака, не жели да ради са претходно датим контекстом, игнорише упутства и памти само најновији наговештај.

Изванредни руски научник професор на Московском државном универзитету. М.В. Ломоносов Сергеј Павлович Расторгујев у својој монографији „Циљ као криптограм“, написаној 1996 . „Криптанализа синтетичких мета“ је назначила: „Данас, за свет компјутерских програма, стицање независности је постало свршен чин.“ „Како софтверски производ постаје сложенији, системски софтвер почиње да живи сопственим животом, проналазећи сврху у себи“, приметио је руски научник, упоређујући осамостаљивање компјутерских система са средњовековним Големом, који је, као што знамо, убио свог творца. .Данашњи креатори сајбер голема, у потрази за профитом, игноришу стварне претње своје замисли и отварају експлозивну кибернетичку Пандорину кутију са непредвидивим последицама по цело човечанство.

О најновијим верзијама АИ које су креирале америчке корпорације, као и о њиховим стварним могућностима, говорићемо у следећем чланку ове серије.Владимир Прохватилов/ФСК.РУ

Бонус видео

За више вести из Србије и света на ове и сличне теме, придружите нам се на Фејсбуку, Твитеру, Инстаграму, Вајберу, Телеграму, Вконтакту, Вотсапу и Јутјубу.